Big Data (большие данные) – это массивные сложные структурированные и неструктурированные наборы данных, которые быстро генерируются и передаются из самых разных источников.

Данные постоянно обрабатываются, когда мы открываем приложения, ищем что-то через Google и даже когда меняем своё местоположение на карте. Это огромные массивы ценной информации, которые необходимо хранить, визуализировать и анализировать крупным организациям для различных целей.

Традиционные инструменты обработки данных не приспособлены для работы с таким большим объемом. Вот почему были созданы множество специализированных программ и архитектурных решений, предназначенных для управления нагрузкой.

Big Data состоит из трёх атрибутов: объем (огромное количество хранимых данных), скорость (скорость, с которой потоки данных должны обрабатываться и анализироваться) и разнообразие (различные источники, из которых собираются данные). А теперь взглянем подробнее на каждый атрибут.

Объем

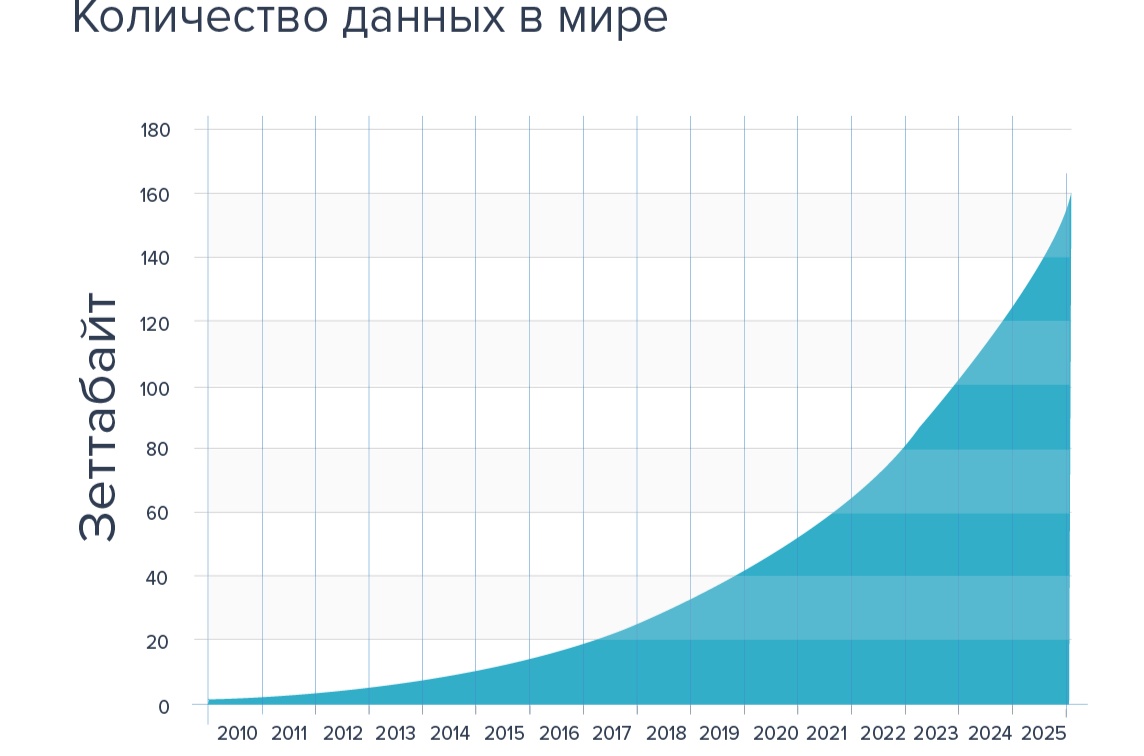

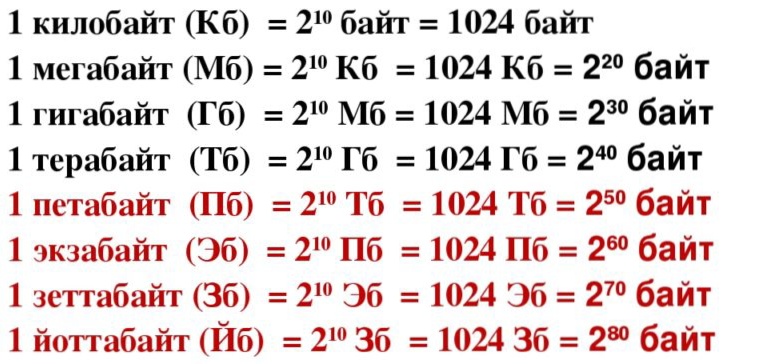

Традиционные данные измеряются в привычных размерах, таких как мегабайты, гигабайты и терабайты. В то время как данные Big Data хранятся в петабайтах и зеттабайтах.

Чтобы понять, насколько велика разница в масштабе, рассмотрим это сравнение на простом примере. Один гигабайт эквивалентен семиминутному видео в формате HD. А вот один зеттабайт равен 250 миллиардам DVD-дисков с памятью 4,5 гигабайта.

Это только верхушка айсберга. Согласно отчету специалистов, цифровая вселенная удваивается каждые два года. И к концу 2020 года, как ожидается, достигнет 44 триллионов зеттабайт.

Big Data обеспечивает архитектуру для обработки такого рода данных. Без соответствующих решений для хранения и обработки информации было бы невозможно добывать инсайты.

Скорость

В Big Data все процессы происходят максимально быстро. От скорости создания информации, до количества времени для её обработки и анализа. Специалисты в шутку описывают этот процесс как попытку выпить из пожарного шланга.

Компании и организации должны иметь возможность быстро использовать текущие данные и генерировать их в режиме реального времени. Обработка информации в реальном времени даёт преимущество в конкурентной борьбе. Такой подход позволяет работникам быстро принимать решения и действовать.

Некоторые формы данных могут быть обработаны в пакетном режиме и оставаться актуальными в течение долгого времени. Но большая часть информации потоком поступает в организации и требует немедленных действий для их обработки. Иначе она будет утеряна, либо утечет в другие руки.

Отличным примером могут служить данные датчиков медицинских устройств. Способность мгновенно обрабатывать данные о состоянии здоровья может предоставить пользователям и врачам потенциально полезную для спасения жизни информацию.

Разнообразие

Примерно 95% всех данных в Big Data неструктурированы. Это означает, что их нелегко вписывать в традиционную модель хранения и обработки информации. Все – от видеофайлов и до научных и метеорологических данных, может представлять собой большой поток информации разного рода. И каждый из них имеет свои уникальные атрибуты.

Платформы Big Data

Платформы Big Data специально разработаны для обработки непостижимых объемов данных, с высокой скоростью и широким разнообразием поступающих в систему. Эти платформы обычно состоят из различных серверов, баз данных и инструментов бизнес-аналитики. Они позволяют работникам Big Data манипулировать информацией, чтобы обнаружить тенденции и закономерности.

В итоге

Тема Big Data, по своей сути – необъятна. Вот почему в следующей статье мы продолжим ее и расскажем вам о том, как и где используется Big Data.